日前,全国政协双周协商座谈会召开,关注人工智能发展中的科技伦理与法律规制—— 引技术向善,驭智能之“火”

华为5G体验馆中的设备。新华社发

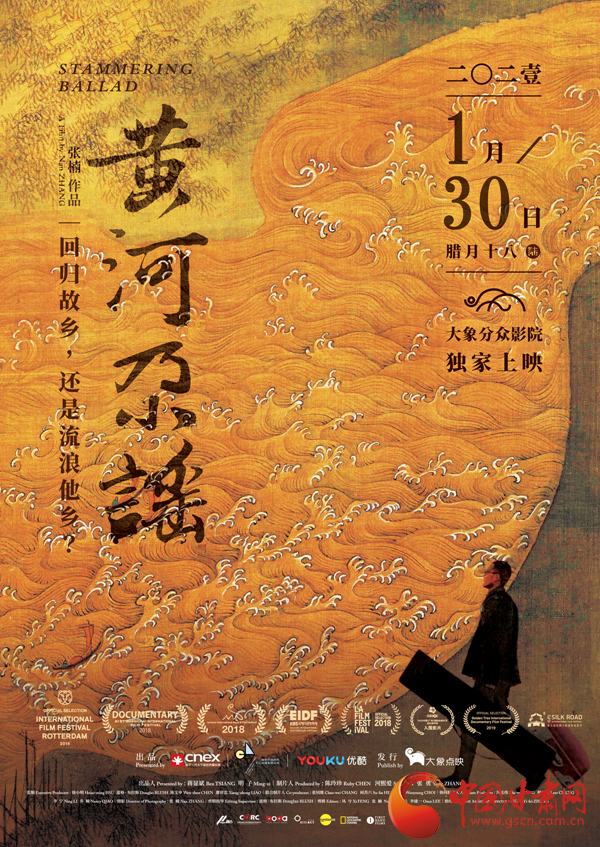

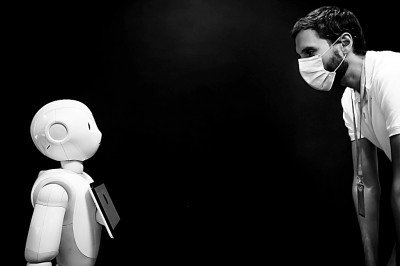

在法国巴黎的软银机器人公司,机器人Pepper展示检测人们是否正确佩戴口罩的功能。新华社发

利用人工智能技术研发的医学检测系统。新华社发

一辆智能网联汽车在路上行驶。新华社发

受新冠肺炎疫情影响,英国取消了A-levels考试(类似中国的高考)。英国教育部门同英国资格与考试监督办公室合作,决定使用算法自动生成学生的A-levels成绩。算法估分方案出台之后,由于考生认为所得分数不公,最终英国政府不得不叫停了这一方案,回到由各校教师提供预估成绩来评定的方案。

英国算法估分方案被叫停,可以说是一次影响广泛的对“算法”的对抗,从一定程度上说明人工智能并非万能,算法也会“失算”。

随着人工智能技术的极大进步,人们对“算法”已不再陌生。商家越来越多地使用算法为客户提供精准服务,政府、学校、医院等机构也会利用算法来帮助其日常工作。以算法与数据为基石的人工智能正深刻地改变人们的生产生活方式。但人工智能作为一项渗透性、实用性极强的崭新技术,具有技术属性和社会属性高度融合的特点,在加速应用推动社会生产力跃升的同时,也带来伦理和法律挑战。

注重技术与伦理的平衡,通过多元协同治理确保“人工智能向善”,逐渐成为社会关注的焦点和人工智能产业健康可持续发展的关键。

人工智能向善需要迈过几道坎?

据报道,有上班族反映,公司给员工发了一批智能坐垫,结果没几天自己就被公司的人事部门“盯”上了,被质问为什么某个时间段不在工位上。没想到坐垫上的数据不只员工自己手机可看,人事部门也看得一清二楚。有网友评论,“代入感太强,已经感到不适了”。

从公司智能坐垫、社区“刷脸”,到各类网站、手机App,个人信息泄露已经成为普遍现象。虽然对此深恶痛绝,但个人想要切断数据流,并没那么容易。有人形容大数据时代的人为“有用的透明人”。人们每天有意无意地在互联网上留下大量个人信息,人工智能技术将这些碎片化信息进行整合,并在不同算法模型中调用这些信息,从而创造出价值。

“加强隐私保护,应当是人工智能开发、应用中的伦理道德底线。”重庆医科大学校长黄爱龙说。上海众人智能科技有限公司董事长谈剑锋提到,尤其需要保护的是不可再生性数据,比如人脸、指纹、DNA等生物特征数据,以及个人医疗档案数据等。这些数据具有唯一性,是无法更改的,一旦被采集到不安全的网络上,极有可能带来灾难性后果。“必须提前设防,在使用规范上有更加严格的要求,防范各类风险。”

基于人工智能的发展特性,过于严苛的数据保护可能会阻碍其发展。如何兼顾数据保护和科技发展,是实现人工智能向善的第一道关卡。

人工智能的核心是数据与算法。众所周知,算法正在以前所未有的速度渗透到我们的工作生活中,算法偏见、算法歧视也越来越被人们感受到。

算法偏见有其客观原因,比如原始数据不完整或被污染;算法本身的局限性,有时算法过于复杂,难以及时发现其漏洞;设计者无意识的偏见或价值观的偏差等。但算法的有意“歧视”更值得高度关注,比如那些进行大数据“杀熟”的商家、倾向于给男性推荐高薪岗位的招聘网站等。由于算法的不透明和难以理解,有时候人们很难看出其中的歧视属性。因此很多人在毫不知情的情况下,承受着各种微妙的歧视和精准的不公。

如何通过技术升级和规范治理,最大程度消除算法偏见和歧视,是人工智能向善的又一道关卡。

除了数据保护和算法伦理,人工智能向善还应考虑人工智能发展可能带来或已带来的社会问题,比如如何缓解人工智能可能加剧的不平等现象、如何平衡人工智能的发展与失业问题、如何防范人工智能犯罪、如何应对人机交互式产品广泛应用对人类情感体验和家庭关系的冲击等。

在中国社科院哲学所科学技术哲学研究室主任、研究员段伟文看来,对技术的伦理追问不应仅关注已存在的价值冲突或被动地等待伦理难题的出现,而应该积极地对其进行前瞻性评估,全面权衡可能的伦理影响。技术伦理审度的关键在于揭示技术对世界、社会和未来的建构中固有的不透明性,不断提高洞察新技术及其运作机制的能力,使其中可能存在的不确定性风险、不公正的情况乃至失控的危险得以及时纳入伦理辨析与考量之中。

“以技制技”成为共识

2020年,针对用户反映强烈的App违规收集与使用用户个人信息等突出问题,工信部累计巡查了4.8万余款App,专项检查了200余款App。目前巡查App采用的还是人工和技术结合的方式,巡查数量有限,且存在漏洞。App监管需要创新治理方式,加强技管结合,持续提升App技术检测能力。

据悉,工信部正加快推进全国App技术检测平台建设,通过线上线下、联防联控体系建设,提升App自动化检测和处理能力。同时,牵头制定《App收集使用个人信息最小必要评估规范》等一系列标准,为规范信息采集行为提供技术准则。

在人工智能的治理与风险防范方面,法律规制必不可少,但实践证明,光有法律不一定能起到应有的效果。就个人信息保护来说,立法正在逐步推进,但由于违法成本低、监管难度大、个人维权难等,个人信息泄露的问题并没有得到有效的解决。

为此,黄爱龙提出构建“制度+科技”的治理机制。“以技制技”,以科技的力量助推人工智能治理,是专家学者和业界人士的共识。

新兴技术一般具有高度专业化的特点,人工智能更是如此。比如算法歧视的治理,最大的挑战在于要搞懂算法并发现其潜在的歧视属性。这就意味着,监管部门需要提升理解、评估和治理算法歧视的能力,这对人才和技术都提出了很高的要求。

当前我国人工智能技术的应用已经走在世界前列,传统的事前监管、行政命令等治理理念和方式已难以适应技术的快速迭代,各类应用场景快速涌现,也增加了发展的不确定性。人工智能发展如何公平地服务于人类的公共利益,不侵害人类社会的公平与正义,需要不断创新治理方式。业界呼吁敏捷灵活的治理措施,立法和监管都应把握合理的限度,要避免因矫枉过正而阻碍人工智能的创新发展。

不同国家之间人工智能相关标准的制定、开放平台的搭建、合作共享框架的形成,对创新全球治理机制也提出了全新挑战。全国政协社会和法制委员会副主任、公安部原副部长陈智敏认为,我国应立足先发优势,积极参与和引领人工智能治理国际规则制定,为构建适应人类命运共同体安全发展需要的人工智能全球治理新规则新秩序新格局,贡献中国智慧和中国方案。

用科技伦理确保人工智能正向应用

科幻作家阿瑟·克拉克曾在小说中写道:“任何足够先进的科技,都与魔法无异。”在人工智能技术高速发展的今天,我们的生活确实像被施了魔法一样。但科技不是独立于现实的乌托邦,科技能向善也能为恶。在全面增强人工智能技术创新能力的同时,构建多部门协同、多学科融合、多元主体参与的治理框架和工作体系,已经是十分紧迫的问题。

深度合成技术可能引发政治风险、个人信息可能被窃取倒卖引发刑事犯罪、“数据投毒”会导致人工智能系统误判……陈智敏指出,应尽快建立数据安全保障、算法安全审查等制度,为人工智能发展形成正确价值导向和稳定社会预期提供有力保障。

因人工智能的高度专业化、知识化和技术化,圈外人很难对其中的风险和不确定性进行准确判断。为此,在科研人员中弘扬“科技向善”理念显得尤为重要。在诸多专家学者和业界人士看来,人工智能治理离不开科技共同体内部的风险预警和自我反思。

我国人工智能治理目前已得到高度重视,取得可喜进展。比如,成立由15个部门构成的人工智能规划推进办公室,统筹推进包括人工智能治理在内的任务落实;在科技创新2030—“新一代人工智能”重大项目中,组织开展人工智能伦理和立法问题研究等。上海正积极建设人工智能综合性研究机构,建设面向人工智能主流技术的算法评测标准体系和通用算法库。同时,加快制定医疗重点领域人工智能产品和服务责任认定条例,开展人工智能产业发展监管、人工智能数据安全等立法调研。

正如有网友写道:“从钻木取火的原始时代到计算机时代,人类一直走在学习科技、利用科技、掌控科技的路上,其间虽然走了一些弯路,但终究作出了一次次善的选择,找到了正确的驭‘火’之术。”我们有理由相信,当人工智能科技伦理得到越来越多的关注和讨论,构建出一套行之有效的人工智能治理规则将不再遥远。

(本报记者 龚亮)

相关新闻

- 2017-01-20陇周刊(2017年 第3期)

- 2017-01-26陇周刊(2017年 第4期)

- 2017-02-10 陇周刊(2017年 第5期)

- 2017-02-17 陇周刊(2017年 第6期)